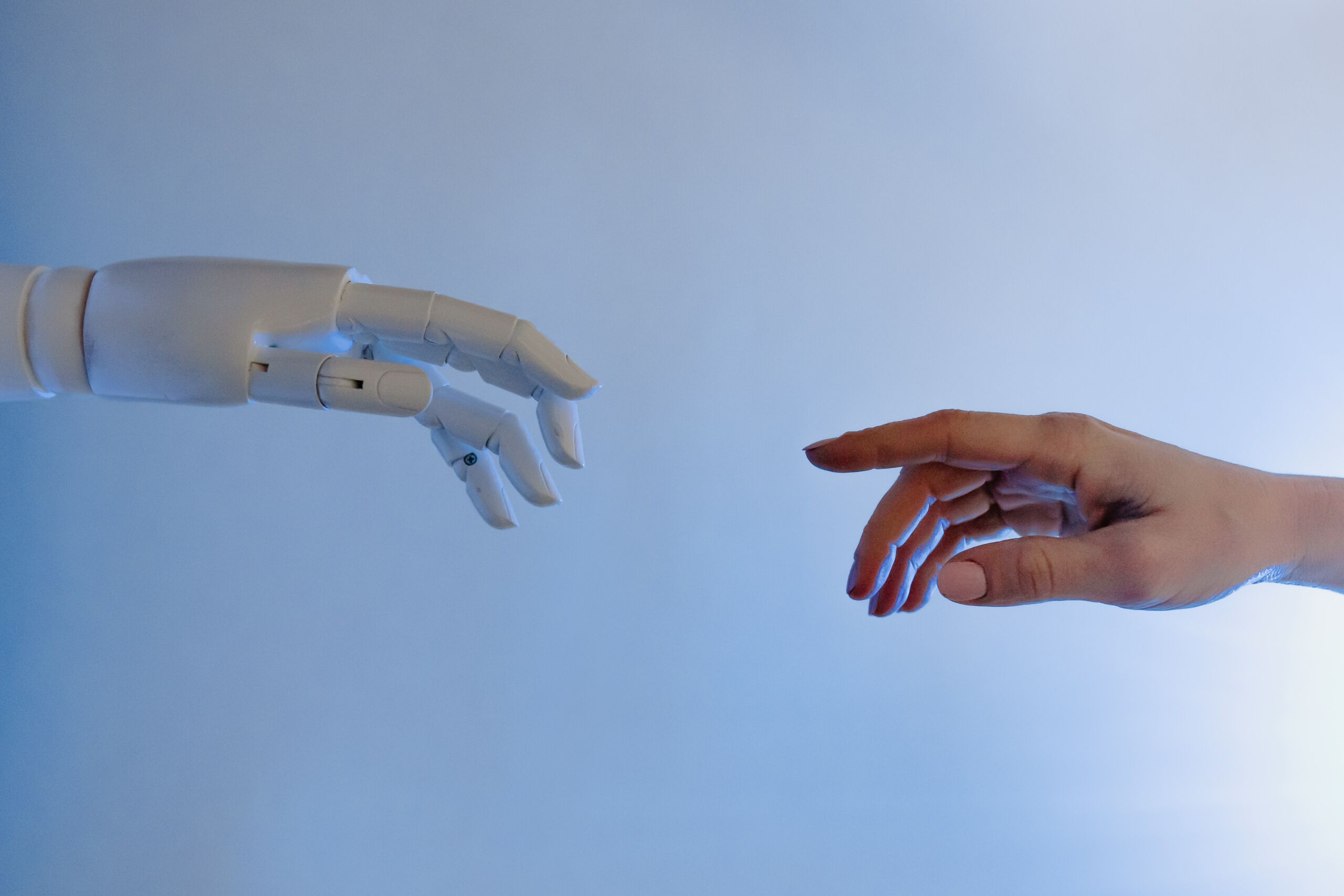

Experiencia de flujo o valle inquietante ¿Qué siente el cliente ante las máquinas?

Entender qué opinan los clientes sobre la intrusión de la inteligencia artificial en sus vidas privadas por parte de las marcas es relevante ya que los usuarios demandan productos personalizados y adaptados a sus necesidades y sin embargo, hay un rechazo demostrado y documentado sobre el miedo a que seamos manejados por algoritmos.

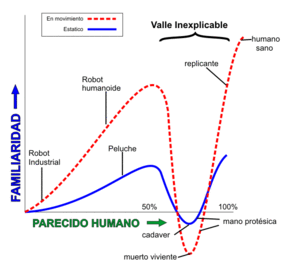

El denominado valle inquietante (Masahiro Mori, 1970 citado en Sugiyama, 2021) refleja el temor que tenemos los humanos a las máquinas que empiezan a aprender y adoptan aspectos que revelan su cercanía a nuestro mundo conocido, sobre todo, cuando estas máquinas tienen una representación física o nos vemos reflejados en su comportamiento.

Curiosamente, nos apasiona el reto que supone la tecnología, denominado experiencia de flujo (Nakamura, & Csikszentmihalyi, 2020) hasta que empieza a humanizarse (El País, 2018, ). Esta es la razón de por qué las empresas tecnológicas apuestan por maquinas que parezcan robots, sin aspecto humano, para eliminar el malestar de la duda. Los expertos lo relacionan con nuestro instinto de supervivencia, basado en el miedo a lo desconocido y la sensación de control que necesitamos de nuestro entorno y cuando una máquina no produce respuestas esperadas, la sensación de alarma se dispara.

Valle inquietante o tecnofobia, es una realidad que el uso de la inteligencia artificial por parte de las empresas e instituciones produce rechazos. Sin embargo, a pesar del temor a ser estudiados por las máquinas y las marcas, el marco de referencia revela que los clientes quieren ser conocidos por sus compañías y cocrear con ellas en busca de soluciones a sus problemas. Hasta un 70% considera que el feedback forma parte de la relación con el cliente (Medallia & Neovantas y Asociación DEC, 2021) pero, como dice Marquerie (2021) “Lo único que nos diferencia de las máquinas es el miedo”.

Sabemos que la Inteligencia artificial ha llegado para quedarse pero necesita datos de las personas (big data y small data, Lindstrom, 2016) y tiene un largo camino simular el pensamiento humano, basado en el lenguaje y el razonamiento, para comprender el entorno y tomar las mejores decisiones. En este punto quería centrar esta reflexión.

En décadas pasadas, el machine learning se basaba en conjuntos de descripciones que se proporcionaban a las máquinas como léxico a controlar (Labeled LDA ) en fuentes de datos, estructurados o no y que sus algoritmos de análisis permitían encontrar e identificar en el entorno, aprendiendo nuevos tópicos. Son los llamados Machine Learning based Models for Semantic Recognition. Su entrenamiento continuo es imprescindible para entender el lenguaje humano en los diferentes contextos de la relación. Sin embargo, no ha sido hasta la inclusión de las tres dimensiones del modelo ABC (affection, behavior intention, and cognition towards en Freedman et al., 1978; Rosenberg et al., 1960; Sears et al., 1995) que podamos hablar de la utilidad de los machine learning como aplicación a la teoría de la actitud del consumidor.

Por tanto, toda acción para entrenar y mejorar estos semantic recognition framework, establecer nuevo vocabulario, conectar con las emociones y comprender el contexto se revela como tarea de gran responsabilidad y sujeto a limitaciones éticas ya que permitirán la toma de decisiones automáticas adecuadas o, por el contrario, perjudiciales o éticamente cuestionables.

Y precisamente porque este aprendizaje de la semántica automática debe ser universal, en un mundo de economía global y donde cada entrenamiento produce decisiones de inteligencia artificial cada vez más complejas, que no puede producirse un mal o sesgado aprendizaje de las máquinas. Aunque estemos en la era de las redes neuronales, Deep Learning (Orange, 2021) y el conocimiento se distribuya en capas que comparten juicios de valor, el aprendizaje siempre se basará en el entorno y en los patrones que se le suministren.

Entonces ¿estamos pues en una disyuntiva que podríamos considerar la existencia de una Psicológica de las Máquinas? Evidentemente no, porque su etimología apela al alma, pero es indudable que el aprendizaje debe ser controlado y bien realizado si queremos que nuestra relación con las máquinas sea la realidad de propugna Kotler (Kotler et all, 2021, creadores del concepto de Marketing 5.0), Tecnología + humanidad.

M Dolores Méndez Aparicio

Manager de Aplicaciones en Mutua Madrileña

Dra. En Economía

maulemam@gmail.com

linkedin.com/in/dra-mª-dolores-méndez-aparicio-06a02790

https://orcid.org/0000-0003-1787-8031

Referencias:

- Nakamura, J., & Csikszentmihalyi, M. (2020). 20 The Experience of Flow. The Oxford Handbook of Positive Psychology, 279.

- El País (2018). Por qué los robots que tienen forma humana dan mal rollo. https://elpais.com/retina/2018/01/31/talento/1517402900_772809.html

- Sugiyama, A. (2021). The Acceptance of Incompleteness: How Wabi-sabi aestheticism allows Japanese society to avoid the Uncanny Valley and integrate robotics into daily life.

- Lindstrom, M. (2016). Small data: The tiny clues that uncover huge trends. St. Martin’s Press

- Kotler, P., Kartajaya, H., & Setiawan, I. (2021). Marketing 5.0: Technology for humanity. John Wiley & Sons

- Medallia & Neovantas y Asociación DEC (2021). Innovación en gestión de la experiencia: Señales desestructuradas y economía conductual. https://asociaciondec.org/cx-tech-day-2021/

- Marquerie, (2021). https://www.computerworld.es/tendencias/lo-unico-que-nos-diferencia-de-las-maquinas-es-el-miedo

- Orange (2021). ‘Deep learning’ and ‘machine learning’: how are they different?. https://blog.orange.es/innovacion/deep-learning-vs-machine-learning/

[…] Méndez Aparicio y Asociación DEC (2021). Experiencia de flujo o valle inquietante ¿Qué siente el cliente ante las máquinas? https://asociaciondec.org/blog-dec/experiencia-de-flujo-o-valle-inquietante-que-siente-el-cliente-an… […]

El humano por naturaleza le teme en cierta forma a todo aquello sobre lo cual no puede tener un control total, o a lo desconocido, hasta q comienza a aprender